Как сделать офлайн зеркало сайта

Добавил пользователь Morpheus Обновлено: 03.10.2024

Ну что ж, скопировать сайт целиком это уже давно не проблема, надо лишь выбрать подходящий для себя способ. А их три:

- Открывать каждую страничку и сохранять на диск

- Использовать онлайн-сервисы

- Пользоваться специальными программами

А теперь подробнее о последних двух способах.

Онлайн-сервисы

Как несложно догадаться из названия – это специальные сайты, с помощью которых можно скачать другие сайты из интернета. Преимущество данного подхода в том, что не нужно устанавливать дополнительных программ, и, соответственно, не важно какая операционная система установлена. Вроде бы всё классно – вставил имя сайта, нажал скачать, и получаешь готовый архив. Но на деле всё оказалось не настолько радужным.

Недостаток сервисов в том, что их мало, а те что есть, работают так себе, либо просят денег. Лично у меня ни разу не получалось скачать даже одностраничный сайт. Сервисы показывали процесс загрузки и зависали. Но тем не менее, список прилагаю:

В общем у меня сложилось впечатление, что эти сервисы либо глючат, либо грузят не совсем то, что хотелось бы, либо годятся только для маленьких сайтиков.

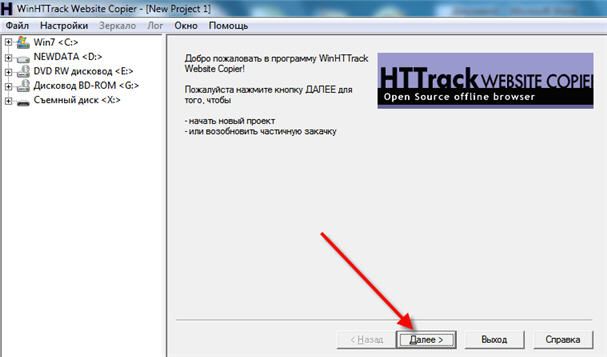

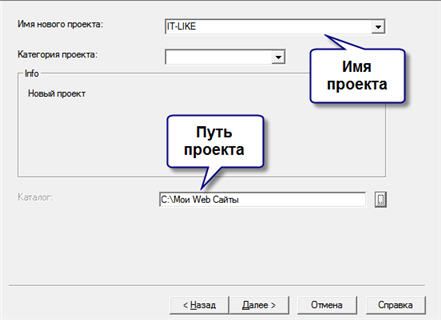

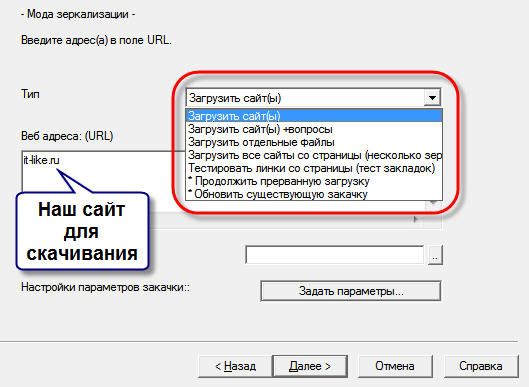

Программа WinHTTrack WebSite Copier

Всё самое нормальное — платное, но есть варианты. Бесплатное решение — программа WinHTTrack WebSite Copier. Хотя это ненашенский продукт, русский язык имеется, его нужно выбрать после установки программы.

Вы можете посмотреть видео или читать дальше статью:

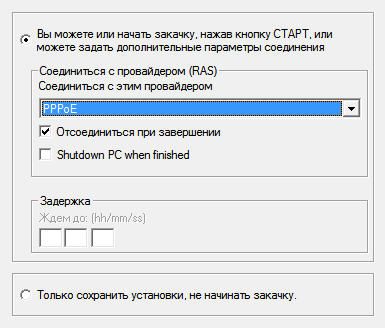

Здесь же можно задать дополнительные параметры, которые могут сократить время загрузки. По умолчанию можно ничего не менять, программа и так отработает нормально. Но всё же рекомендую обратить внимание на некоторые параметры:

Готовый сайт можно открыть двумя способами.

- из папки, в которую сохраняли проект, кликнув по файлу index.html. В этом случае откроется страница со списком всех проектов. Нужно выбрать интересующий.

- из папки с именем самого проекта, кликнув по файлу index.html. В этом случае сразу откроется сайт.

Скрипт DollySites

Я лично пользуюсь платным скриптом, но чтобы его установить нужен хостинг и немного опыта. Но зато скрипт работает очень хорошо, все скопированные мною сайты открывались один-в-один как в оригинале. Этому скрипту посвящена отдельная статья. Я его использую для создания копий лендингов, но работает он с любыми, даже самыми большими сайтами.

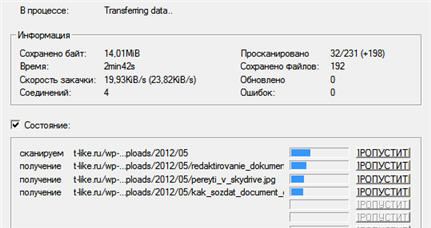

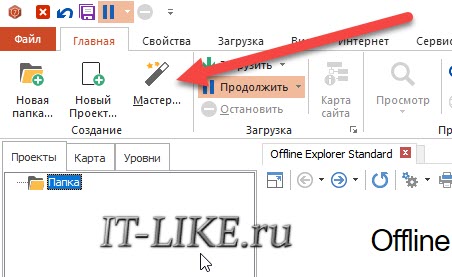

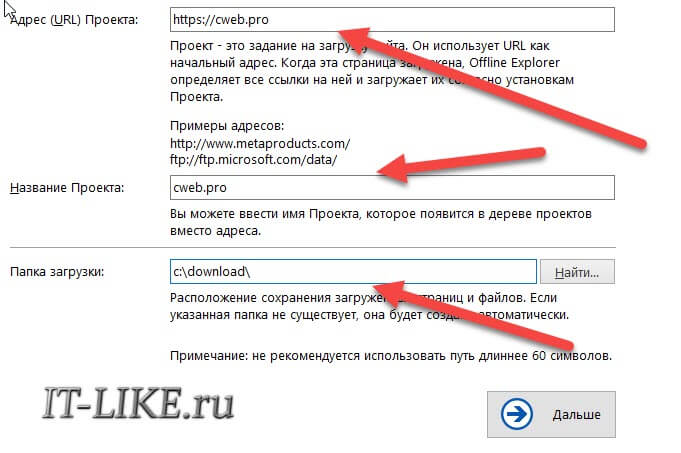

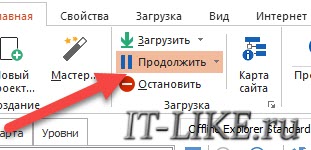

Offline Explorer

Платная программа-комбайн, есть демо. Из явных отличий от WinHTTrack:

Интерфейс покажется более замороченным, но ничего сложного в нём нет. Запускаем мастер:

Выбираем один из 12 шаблонов:

По окончанию загрузки придёт уведомление на рабочий стол.

Из платных, ещё можете попробовать некогда легендарную программу Teleport Pro (на английском), но по-моему за неё просят намного больше, чем она стоит, да и устарела уже.

Какие есть ограничения у копий

Хочу внести ясность, что скопированный проект, даже если он точь-в-точь будет выглядеть как оригинал, это не означает что будут работать все функции. Не будет работать функционал, который исполняется на сервере, т.е. различные калькуляторы, опросы, подбор по параметрам — работать не будут 99%. Если функционал реализован с помощью Javascript, то будет работать.

Перенасыщенность информацией является реальностью наших дней. Не всегда есть время на чтение статей из 5000 слов и интересного интервью, когда вы увидели его у себя в Twitter. Существуют сервисы, которые дают возможность сохранять понравившиеся статьи и потом читать их даже без доступа в интернет.

- Скачивание файла

- Скачивание в Chrome на Android

- Добавление в список чтения Safari

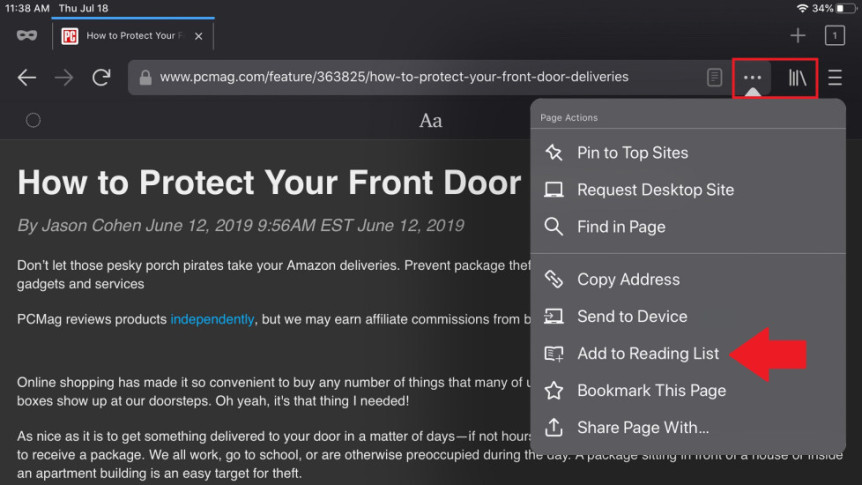

- Добавление в список чтения Chrome на iOS

- Добавление в список чтения Firefox на iOS

- Активация режима офлайн в Firefox на компьютерах

- Сохранение при помощи Pocket

- Сторонние инструменты

- Кэшированная версия сайта

Вы можете быть в метро, в зоне с плохим покрытием или у вас кончилась суточная норма трафика. Во всех этих случаях приложения для чтения офлайн могут прийти на помощь.

Многие программы и браузеры поддерживают режим офлайн-чтения на любом мобильном устройстве. Давайте узнаем, как скачать понравившиеся вам статьи.

Скачивание файла

Сохранение через Chrome

Chrome позволяет сохранять веб-страницу целиком, включая текст и мультимедиа, или просто текст HTML. Edge может делать так же, но также позволяет скачивать многочисленные файлы в один файл или только HTML. Firefox даёт выбор между полным набором файлов сайта, файлом HTML или простым текстовым файлом. В браузере Safari можно выбирать между архивом с текстом и мультимедиа или только текстом.

После этого можно скачать нужный вам файл на компьютер и читать его в любое время. Веб-страница будет загружаться как локальный файл и работать даже без доступа в интернет.

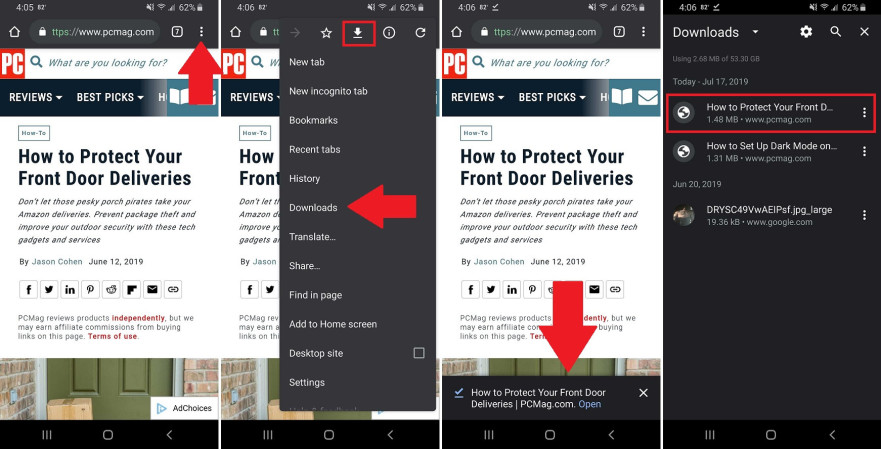

Скачивание в Chrome на Android

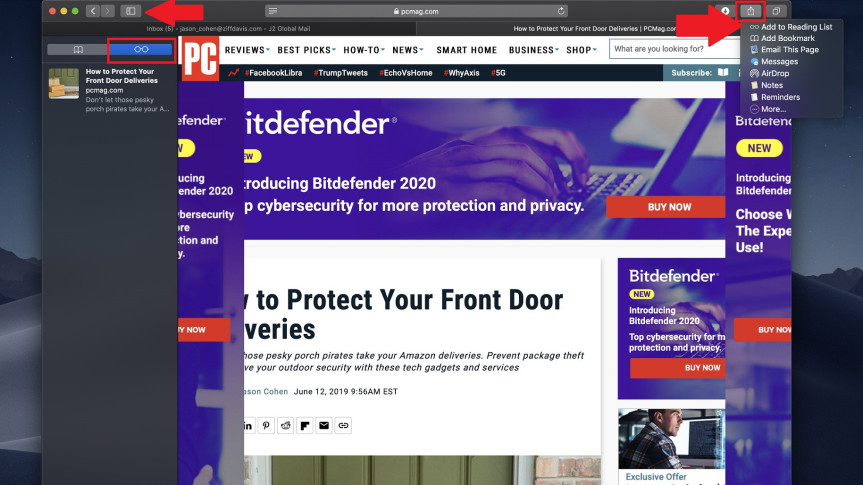

Добавление в список чтения Safari

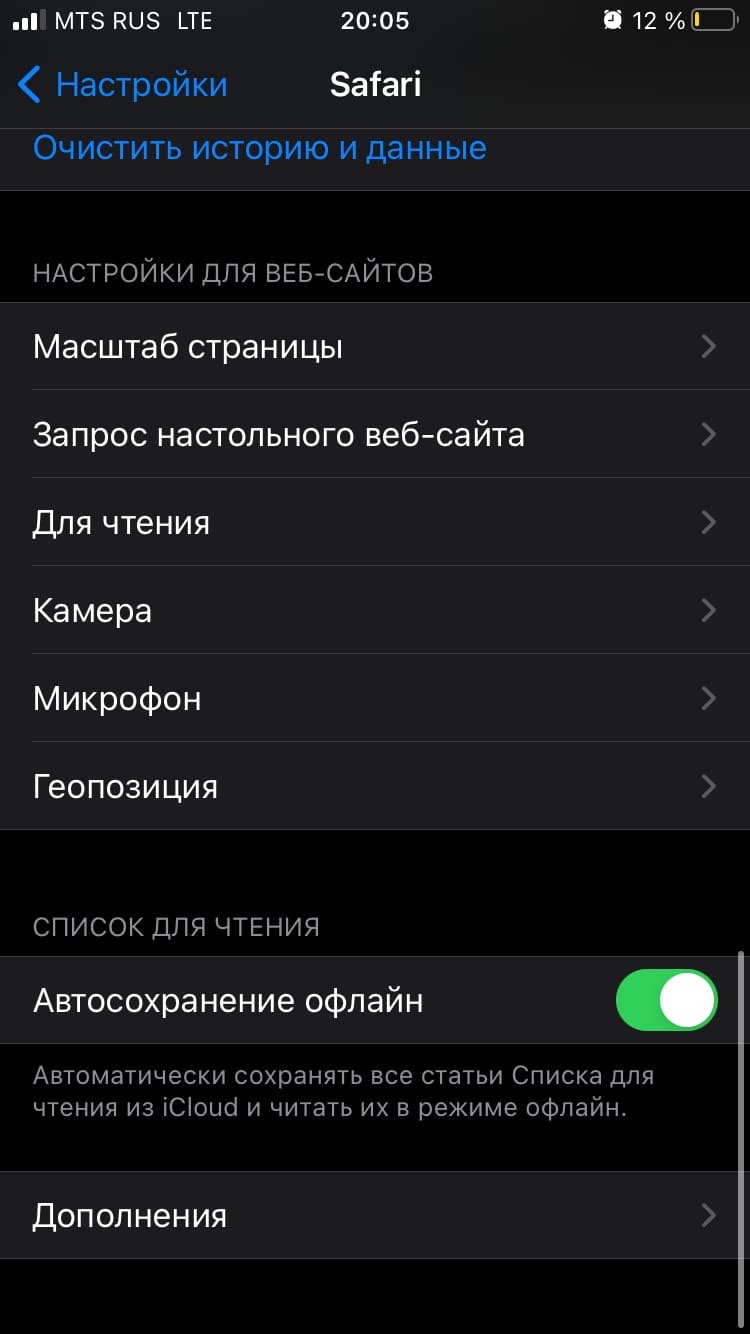

При просмотре веб-страницы в браузере Safari в системах macOS или iOS можно сохранять эти страницы в список чтения. По умолчанию список чтения не позволяет получать доступ к сохранённым объектам офлайн.

Добавление в список чтения Chrome на iOS

Добавление в список чтения Firefox на iOS

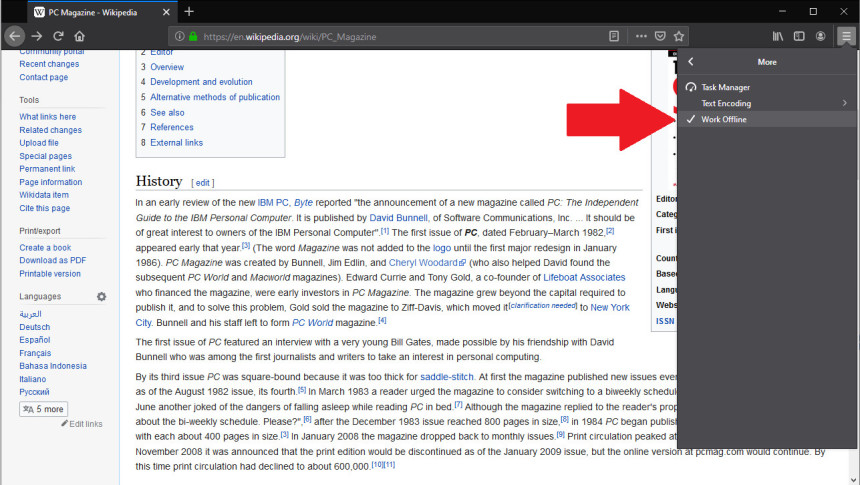

Активация режима офлайн в Firefox на компьютерах

Когда вы работаете в интернете, история браузера сохраняется в кэше. Firefox даёт возможность нажать на кэш для чтения офлайн. Откройте гамбургер-меню и выберите Дополнительно > Работать офлайн. Доступ к интернету из браузера отключится, зато вы сможете получить доступ к недавно просмотренным страницам.

Начните набирать адрес сайта в адресной строке или откройте гамбургер-меню и выберите Библиотека > История для получения списка недавно посещённых страниц. Это не идеальное решение, но с его помощью можно получить доступ к нужной странице.

Сохранение при помощи Pocket

Pocket позволяет сохранять статьи из интернета и синхронизировать их между разными устройствами, такими как компьютеры, Mac, мобильные устройства на iOS и Android. В 2017 году приложение приобрела компания Mozilla, поэтому теперь оно встроено в Firefox, а также есть расширения для браузеров Chrome, Safari, Edge.

Сторонние инструменты

Есть много приложений сторонних разработчиков, которые способны сохранять статьи для чтения офлайн. Также есть расширения для браузеров, бесплатные утилиты и приложения для чтения. Расширение Save Page WE для браузера Chrome IE Firefox сохраняет веб-страницы на компьютер по одному нажатию. Можно задать настройки для указания того, какой объём информации должен быть сохранён.

Среди наиболее продвинутых решений можно назвать утилиту HTTrack для Windows, Linux и Android, а также SiteSucker для macOS и iOS. Эти программы могут скачивать целые папки веб-сайтов по URL-адресу, позволяя осуществлять навигацию по сайту без доступа в интернет.

Как сделать так, чтобы пользователь смог использовать ваш сайт, даже если пропало интернет подключение или его вообще нет? Сегодня мы об этом и поговорим.

Для чего это нужно?

Ваши пользователи больше не используют свои десктопные компьютеры, подключенные по проводам к интернету. Они посещают ваш сайт с телефона в лифте, с планшета в метро или с ноутбука, пока тесно сидят на месте 25E.

Именно по этому современные браузеры поддерживают ServiceWorkers, новую технологию, которая позволяет вам предоставлять пользователям доступ к вашему сайту, даже если они не в сети.

UpUp - это бесплатный, open source проект, который позволяет использовать эту современную магию всего лишь вызовом одной команды.

UpUp.start( 'content-url': 'offline.html' // покажет эту страницу пользователям не в сети

>);

Как это работает?

UpUp использует ServiceWorkers для определения потери соединения. ServiceWorkers - это специальный скрипт, который работает в браузере в фоновом режиме и может следить за статусом сети.

Когда пользователь посещает ваш сайт в первый раз, UpUp регистрирует ServiceWorker с вашим браузером и дает ему список файлов, которые нужно закэшировать.

Следующий раз, когда пользователь посещает ваш сайт, ServiceWorker слушает сеть на наличие ошибок. Если соединение потеряно, и ServiceWorker найдет нужные файлы в кеше, то он вернет их также, как если бы они пришли из сети.

Итак, сегодня мы рассмотрели очень интересную технологию, которой, думаю, вы сможете найти применение. Спасибо за внимание!

Если Вы не хотите пропустить новые материалы на сайте,

то Вы можете подписаться на обновления: Подписаться на обновления

Если у Вас остались какие-либо вопросы, либо у Вас есть желание высказаться по поводу этой статьи, то Вы можете оставить свой комментарий внизу страницы.

Порекомендуйте эту статью друзьям:

Если Вам понравился сайт, то разместите ссылку на него (у себя на сайте, на форуме, в контакте):

Она выглядит вот так:

Комментарии ( 3 ):

Полезная статья ребята

Здравствуйте Михаил не могли бы вы написать статью на тему WebRTC видео конференции т.д думаю многим будет интерестно спасибо

Возьмём на заметку! Спасибо!

Такие полумеры не дают желаемого результата и заставляют нервничать, когда вы не можете полностью воспользоваться всеми возможностями веб-ресурса. В такой ситуации я предлагаю отказаться от экспериментов и ознакомиться с парой программ, специально заточенных для выполнения задачи сохранения страниц сайта целиком.

Можно перенести данные из обозревателя в любой текстовый редактор. Для этого лучше всего подойдёт Microsoft Word. В нём корректно отображаются изображения и форматирование. Хотя из-за специфики документа может не очень эстетично выглядеть реклама, меню и некоторые фреймы.

Вот как скопировать страницу сайта:

Иногда получается так, что переносится только текст. Если вам нужен остальной контент, можно взять и его. Вот как скопировать страницу веб-ресурса полностью — со всеми гиперссылками, рисунками:

Способ №1: копипаст

В некоторых случаях нельзя скопировать графику и форматирование. Только текст. Даже без разделения на абзацы. Но можно сделать скриншот или использовать специальное программное обеспечение для переноса содержимого страницы на компьютер.

Сайты с защитой от копирования

Если вы хотите сохранить на компьютер какой-то сайт целиком, не надо полностью удалять теги, чтобы осталась только полезная информация. Можете воспользоваться любым html-редактором. Подойдёт, например, FrontPage. Разбираться в веб-дизайне не требуется.

- Выделите весь html-код.

- Откройте редактор веб-страниц.

- Скопируйте туда этот код.

- Перейдите в режим просмотра, чтобы увидеть, как будет выглядеть копия.

- Перейдите в Файл — Сохранить как. Выберите тип файла (лучше оставить по умолчанию HTML), укажите путь к папке, где он будет находиться, и подтвердите действие. Он сохранится на электронную вычислительную машину.

Защита от копирования может быть привязана к какому-то js-скрипту. Чтобы отключить её, надо в браузере запретить выполнение JavaScript. Это можно сделать в настройках веб-обозревателя. Но из-за этого иногда сбиваются параметры всей страницы. Она будет отображаться неправильно или выдавать ошибку. Ведь там работает много различных скриптов, а не один, блокирующий выделение.

Если на сервисе есть подобная защита, лучше разобраться, как скопировать страницу ресурса глобальной сети другим способом. Например, можно создать скриншот.

Ручное сохранение страниц

Это самый востребованный и легкий вариант для скачивания сайта целиком на компьютер. Некоторые слышали о таком варианте, но не было причин воспользоваться им.

Кажется проще некуда? Этот вариант с небольшим недостатком, у нас есть возможность сохранить только одну страницу, а на сайте страниц много.

Этот способ отличный, если сайт состоит только с одной страницы, а если их больше? В этом случае необходимо сохранять каждую страницу по отдельности, что займет много времени.

Этот вариант для тех, кто не знаком с главными правилами скачивания сайта.

back to menu ↑ back to menu ↑

Скриншот

Снимок экрана — это самый простой способ добавить какую-то информацию на компьютер. Она сохраняется в виде графического файла. Его можно открыть и просмотреть в любое время. Вот как сделать скрин:

Получить снимок страницы можно с помощью графических редакторов. Например, Paint.

Информация будет представлена в виде сплошной картинки, а не набора символов. Если понадобится скопировать какую-то часть материала, придётся перепечатывать его вручную. Ведь скриншот — не статья. Чтобы облегчить задачу, воспользуйтесь утилитами для распознавания текста с рисунков.

Так удобно копировать небольшие куски. Но вот с объёмным контентом сложнее. Придётся делать много снимков, прокручивать, часто открывать редактор. Но можно разобраться, как сделать скрин всей страницы портала, а не её части. Используйте специализированные программы.

Утилиты для создания скриншотов

Существуют программы для работы со снимками экрана. С их помощью можно охватить контент полностью, а не скринить по кускам.

- Популярное приложение с разнообразным функционалом.

- Расширение для веб-браузера. Можно сделать картинку всей страницы, просто нажав кнопку на панели инструментов.

- Снимает всё, что можно снять: произвольные области, окна, большие веб-ресурсы. Есть инструментарий для редактирования получившихся изображений и библиотека эффектов.

- Автоматически прокручивает, делает серию кадров и самостоятельно объединяет их в один скриншот.

Есть также онлайн-сервисы, которые могут сформировать снимок. Они работают по одному принципу: вставить адрес сайта — получить картинку. Вот некоторые из них.

- Capture Full Page

- Web Screenshots

- Thumbalizr

- Snapito

Онлайн скачивание

Этот вариант – отличное решение для тех, кто хочет скачать сайт целиком на компьютер. Уже разработано много разнообразных программ и ресурсов, которые помогут с перекодировкой файлов, с редактированием аудиофайлов.

Одно из самых важных достоинств этого варианта, это то, что нет необходимости захламлять операционную систему лишними утилитами, которыми в лучшем случае вы воспользуетесь только один раз.

Для скачивания достаточно зайти на специальный сайт, вбить адрес нужного вам ресурса, и запустить скачивание, предварительно выбрав папку, где будет храниться сайт.

Теоретически это все просто, а на самом деле найти действительно качественный и безопасный ресурс тяжело, потому что по настоящему их несколько штук.

Конечно, если вы хотите найти бесплатный ресурс.

А остальные хорошие ресурсы, как правило, платные.

Но сейчас хотелось бы рассмотреть именно бесплатные варианты.

Site2Zip com

Бесплатный и, что немаловажно, русскоязычный ресурс.

Действие небыстрое, да и у тех, кто пробует первый раз, может не получиться.

При удачном завершении процесса, то на выходе у нас есть архивированный сайт.

Webparse

С одной стороны вроде бы бесплатный ресурс с одним но. Воспользоваться им бесплатно можно только один раз, дальше за скачивание страниц и сайтов необходимо платить.

Скорость скачивания, безусловно, больше, нежели у вышеописанного ресурса, но уже не бесплатно. На выходе у нас образовывается архив из сайтом.

Глубины парсинга в настройках, к сожалению нет. А это значит убедиться в полной закачке сайта невозможно, необходимо самостоятельно сверять копии и оригинал.

Web2PDFConvert

Соответственно большая часть сайта в процессе потеряется. Если это не будет проблемой, то пользоваться этим ресурсом можно.

back to menu ↑ back to menu ↑

Сохранить как HTML-файл

Вот как сохранить страницу ресурса глобальной сети на компьютер в формате html. Впоследствии его можно будет конвертировать в другой тип. При таком копировании картинки с веб-портала помещаются в отдельную папку, которая будет иметь то же название, что html-файл, и находится в том же месте, что и он.

Как скачать сайт полностью с помощью программ

Конечно, сервисы более простой вариант скачивания сайтов для новичка, но и программы тоже играют важную роль в этом вопросе. Перечислю программы, которые скачают сайт полностью:

В Интернете, Вы найдёте множество таких программ, которые скачивают сайты полностью. Но эти, являются и бесплатными, а некоторые из них недорогими, их может себе позволить любой пользователь.

Сохранить как PDF

В Google Chrome можно создать из страницы PDF-файл. Данная функция предназначена для распечатки на принтере. Но доступно копирование и на компьютер.

Еще один способ — сохранить как PDF-страницу с помощью штатных средств Chrome.

Эта функция доступна исключительно в Chrome. Для других веб-обозревателей нужны плагины. Printpdf для Firefox и Web2PDFConvert для Opera.

HTTrack

HTTrack позволяет пользователям загружать сайт из интернета на жесткий диск. Программа работает путем копирования содержимого всего сайта, а затем загружает все каталоги, HTML, изображения и другие файлы с сервера сайта на ваш компьютер.

При просмотре скопированного сайта HTTrack поддерживает исходную структуру ссылок сайта. Это позволяет пользователям просматривать его в обычном браузере. Кроме того, пользователи могут нажимать на ссылки и просматривать сайт точно так же, как если бы они смотрели его онлайн.

HTTrack также может обновлять ранее загруженные сайты, а также возобновлять любые прерванные загрузки. Приложение доступно для Windows, Linux и даже для устройств на базе Android.

Утилиты для сохранения сайтов целиком

- HTTrack Website Copier.

- Local Website Archive.

- Teleport Pro.

- WebCopier Pro.

Есть много способов перенести страницу сайта на ПК. Какой выбрать — зависит от ваших нужд. Если хотите сохранить информацию, чтобы потом её изучить, достаточно обычного снимка экрана. Но когда надо работать с этими данными, редактировать их, добавлять в документы, лучше скопировать их или создать html-файл.

Сохранение картинок и шрифтов

Помимо сервисов онлайн для скачивания интернет-сайтов, существуют и специальные программы для этого. Как и сервисы, они требуют наличия интернет соединения, но для работы им необходим только адрес сайта.

HTTrack WebSite Copier

Главное окно программы HTTrack WebSite Copier

Также есть ряд настраиваемых параметров:

- тип контента – позволяет задавать доступность изображений, видео и прочих медийных составляющих;

- максимальная глубина скачивания – доля доступного функционала. Большинству сайтов подходит глубина – 3-4 уровня;

- очередность скачиванию – задает приоритет загрузки текста или медиа-файлов.

К недостаткам можно отнести частично утративший актуальность интерфейс.

Скачиваем программу из официального источника

Задаем адрес сайта и тип содержимого

Отмечаем пункты, как на скриншоте

Процесс скачивания сайта, ожидаем завершения

Teleport Pro

Программа с простым и понятным интерфейсам, дружелюбным даже для новичка. Способна искать файлы с определенным типом и размером, а также выполнять поиск, использую ключевые слова. При поиске формирует список из всех файлов со всех разделов ресурса. Однако, у нее хватает и недостатков. Главный из них – платная лицензия. 50 долларов далеко не каждому по карману.

Интерфейс программы Teleport Pro

Offline explorer Pro

Интерфейс программы Offline explorer Pro

Еще одна лицензионная программа. По сравнению с упомянутыми выше, функционал значительно расширен: можно загружать даже потоковое видео, интерфейс более привычен для современных операционных систем. Может обрабатываться до 500 сайтов одновременно, включая запароленные. Программа имеет собственный сервер, что делает ее гораздо автономней прочих программ, не говоря уже об онлайн-сервисах. Позволяет переносить сайты прямиком из браузера.

Главный недостаток большая цена: 60 долларов за стандартную версию, 150 – за профессиональную и целых 600 – за корпоративную. Такие цены делают ее доступной только для узкого круга пользователей.

В закладки

БЕЗ скриптов, макросов, регулярных выражений и командной строки.

Эта статья пригодится студентам, которые хотят скачать все картинки с сайта разом, чтобы потом одним движением вставить их в Power Point и сразу получить готовую презентацию. Владельцам электронных библиотек, которые собирают новые книги по ресурсам конкурентов. Просто людям, которые хотят сохранить интересный сайт/страницу в соцсети, опасаясь, что те могут скоро исчезнуть, а также менеджерам, собирающим базы контактов для рассылок.

Есть три основные цели извлечения/сохранения данных с сайта на свой компьютер:

- Чтобы не пропали;

- Чтобы использовать чужие картинки, видео, музыку, книги в своих проектах (от школьной презентации до полноценного веб-сайта);

- Чтобы искать на сайте информацию средствами Spotlight, когда Google не справляется (к примеру поиск изображений по exif-данным или музыки по исполнителю).

Ситуации, когда неожиданно понадобится автоматизированно сохранить какую-ту информацию с сайта, могут случиться с каждым и надо быть к ним готовым. Если вы умеете писать скрипты для работы с утилитами wget/curl, то можете смело закрывать эту статью. А если нет, то сейчас вы узнаете о самых простых приемах сохранения/извлечения данных с сайтов.

1. Скачиваем сайт целиком для просмотра оффлайн

В OS X это можно сделать с помощью приложения HTTrack Website Copier, которая настраивается схожим образом.

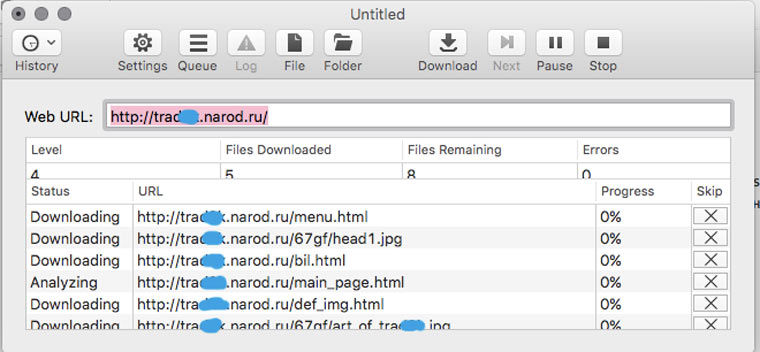

Пользоваться Site Sucker очень просто. Открываем программу, выбираем пункт меню File -> New, указываем URL сайта, нажимаем кнопку Download и дожидаемся окончания скачивания.

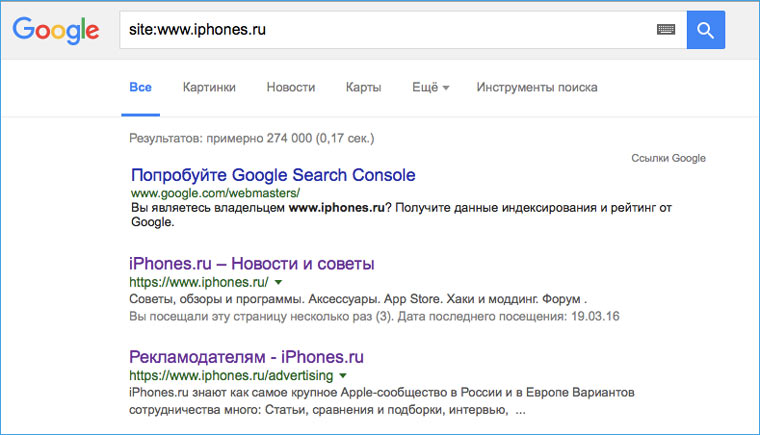

2. Прикидываем сколько на сайте страниц

Перед тем как браться за скачивание сайта, необходимо приблизительно оценить его размер (не затянется ли процесс на долгие часы). Это можно сделать с помощью Google. Открываем поисковик и набираем команду site: адрес искомого сайта. После этого нам будет известно количество проиндексированных страниц. Эта цифра не соответствуют точному количеству страниц сайта, но она указывает на его порядок (сотни? тысячи? сотни тысяч?).

3. Устанавливаем ограничения на скачивание страниц сайта

![]()

Если вы обнаружили, что на сайте тысячи страниц, то можно ограничить число уровней глубины скачивания. К примеру, скачивать только те страницы, на которые есть ссылка с главной (уровень 2). Также можно ограничить размер загружаемых файлов, на случай, если владелец хранит на своем ресурсе tiff-файлы по 200 Мб и дистрибутивы Linux (и такое случается).

Сделать это можно в Settings -> Limits.

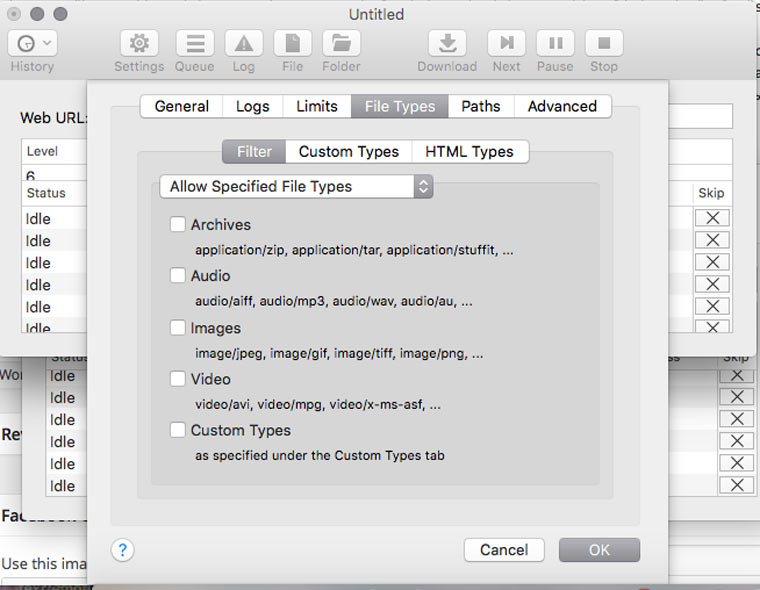

4. Скачиваем с сайта файлы определенного типа

В Settings -> File Types -> Filters можно указать какие типы файлов разрешено скачивать, либо какие типы файлов запрещено скачивать (Allow Specified Filetypes/Disallow Specifies Filetypes). Таким образом можно извлечь все картинки с сайта (либо наоборот игнорировать их, чтобы места на диске не занимали), а также видео, аудио, архивы и десятки других типов файлов (они доступны в блоке Custom Types) от документов MS Word до скриптов на Perl.

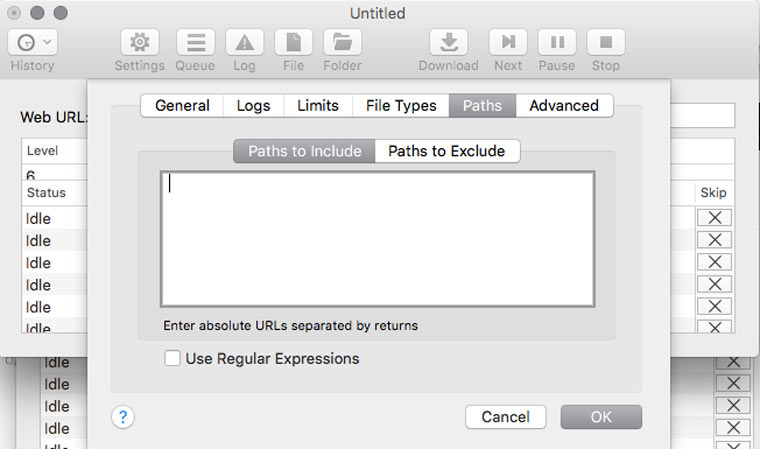

5. Скачиваем только определенные папки

Если на сайте есть книги, чертежи, карты и прочие уникальные и полезные материалы, то они, как правило, лежат в отдельном каталоге (его можно отследить через адресную строку браузера) и можно настроить SiteSucker так, чтобы скачивать только его. Это делается в Settings -> Paths -> Paths to Include. А если вы хотите наоборот, запретить скачивание каких-то папок, то их адреса надо указать в блоке Paths to Exclude

6. Решаем вопрос с кодировкой

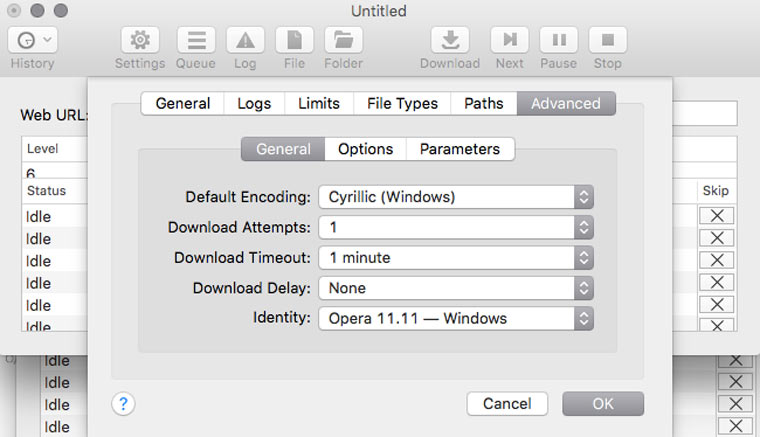

Если вы обнаружили, что скачанные страницы вместо текста содержат кракозябры, там можно попробовать решить эту проблему, поменяв кодировку в Settings -> Advanced -> General. Если неполадки возникли с русским сайтом, то скорее всего нужно указать кодировку Cyrillic Windows. Если это не сработает, то попробуйте найти искомую кодировку с помощью декодера Лебедева (в него надо вставлять текст с отображающихся криво веб-страниц).

7. Делаем снимок веб-страницы

Это может пригодиться для сравнения разных версий дизайна сайта, запечатления на память длинных эпичных перепалок в комментариях или в качестве альтернативы способу сохранения сайтов, описанного в предыдущих шести пунктах.

8. Сохраняем картинки только с определенной страницы

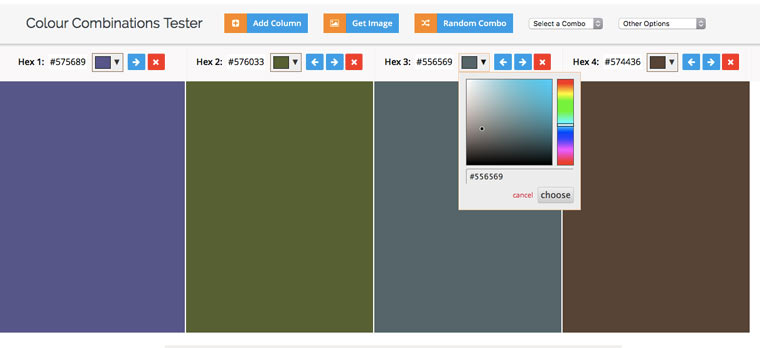

9. Извлекаем HEX-коды цветов с веб-сайта

10. Извлекаем из текста адреса электронной почты

11. Извлекаем из текста номера телефонов

А если надо отфильтровать в тексте заголовки, даты и прочую информацию, то к вам на помощь придут регулярные выражения и Sublime Text.

В закладки

БЕЗ скриптов, макросов, регулярных выражений и командной строки. Эта статья пригодится студентам, которые хотят скачать все картинки с сайта разом, чтобы потом одним движением вставить их в Power Point и сразу получить готовую презентацию. Владельцам электронных библиотек, которые собирают новые книги по ресурсам конкурентов. Просто людям, которые хотят сохранить интересный сайт/страницу в соцсети, опасаясь, что.

Читайте также: