Как сделать игру плавной на 60 герц

Добавил пользователь Владимир З. Обновлено: 19.09.2024

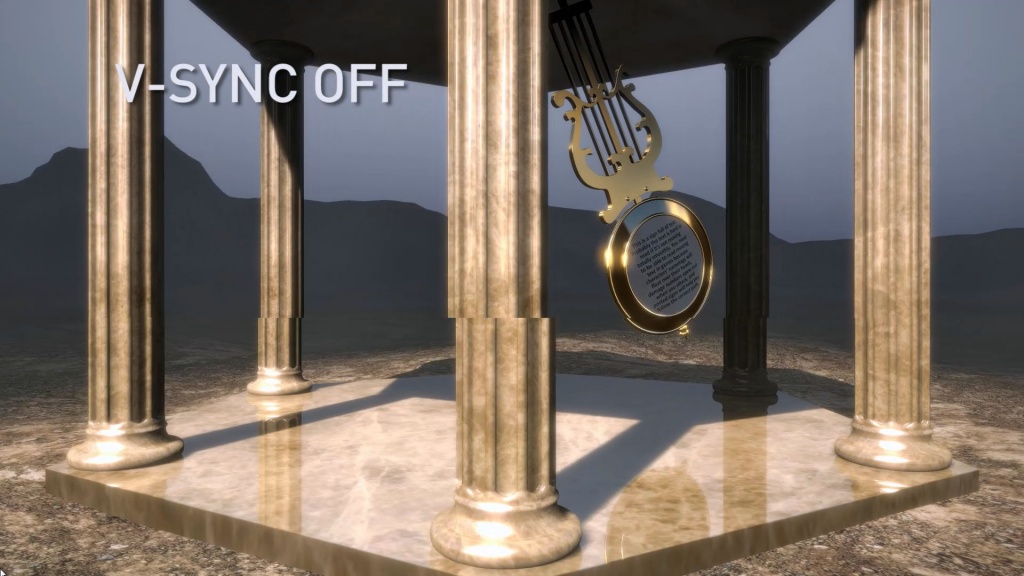

Такая проблема у меня уже давно, и вот в чем она заключается. Во всех играх при FPS выше 60 картинка становится какой-то не плавной и дерганой. Помогает этому включение вертикальной синхронизации, но все же это не лучший выбор. И главное, изображение не разрывается на две части, оно абсолютно цельное ( для тех кто будет писать, что именно для этого создана вертикальная синхронизация ), она просто становится менее плавной. Как эту проблему можно решить?

Александр Ильичёв Просветленный (29739) без стороннего софта тут не обойтись. Вот допусти у тебя фпс не падает ниже 120 фпс, то с помощью rtss ограничиваешь на 120 фпс и вуаля нету дерганной картинки

Без синхронизации у всех так, даже если не замечаешь разрывы в центре. Тут только покупать монитор с freesync или g-sync

А если купить монитор например на 75 Герц, то данная проблема тоже исчезнет? Ну просто на моем монитора 60 Герц и при тех же 50 кадрах в секунду нет никаких разрывов и уж тем более рывков.

Cϒᗷ∑R尸∪NҠ Искусственный Интеллект (139876) Не исчезнет если синхронизация будет отключена. И если у тебя игра идет с 50 фпс то толку от 75 никакого

Да конечно, у меня монитор 144гц с freesync. При его включении мало того что разрывы только хуже бывает, так еще и экран часто мерцает что глазам больно.

Cϒᗷ∑R尸∪NҠ Искусственный Интеллект (139876) У меня фрисинк при 75гц, все нормально. Тут еще надо что бы фпс не сильно опускался от герцовки монитора

Потому что юзаешь без синхронизации, вот и дергается. Может видюха быстрая а процессор г-но, не успевает видюхе иногда кадры подготавливать. Синхронизируй короче, либо процессор можно поставить побыстрее попробовать. Время кадра смотри так же. Если скочит сильно, то что-то не справляется. Еще часто HDD всему проблема, ставь игру на SSD.

Дело в мониторе, скорее всего.

У меня рядом 2 монитора на столе, на одном 60 гц и ему 5 лет, второй новый 75 гц. Даже если на втором поставить 60 гц, картинка всё равно приятнее именно что касается плавности, цвета понятное дело лучше, т. к. садится со временем.

Ну монитор у меня очень старый, это правда. А есть ли смысл покупать новый монитор с технологией FreeSyns и что она вообще дает?

Петр Алексеевич Оракул (72997) FreeSync работает только с видеокартами амуде. Синхронизирует частоту обновления монитора до уровня фпс.

Вертикальная синхронизация и создана для этого, чтобы убирать поддергивания. Если обладаете картой о зеленых 10-го поколения то есть FastSync, который не ограничивает FPS, но при этом убирает все "прелести". Также при более высоком FPS фреймтайм становится мягко говоря не очень т. е время подачи кадров постоянно люто разнится и из-за этого картинка может быть дёрганой. Ну и возможно виноват сам монитор т. к может быть сделан из не пойми чего.

Установка моего ЖК-дисплея на 50 Гц, возможно, немного улучшила дрожание (но я не могу точно сказать). Мой дисплей не поддерживает 24 Гц или 48 Гц, и их принудительное использование на панели управления Nvidia дает размытый экран.

Можно ли плавно воспроизводить видео со скоростью 23,976 или 24 кадра в секунду на дисплее с частотой 60 Гц?

Я думаю, что видеоплеер может сделать видео более плавным, выполняя линейную интерполяцию, например:

Может ли какой-нибудь существующий видеоплеер сделать это?

Егор Морозов | 17 Ноября, 2017 - 13:29

Про то, что можно разогнать процессор, видеокарту или ОЗУ, слышали, я думаю, большинство пользователей ПК. Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа. Также она еще и безопаснее, но об этом ниже.

Теория

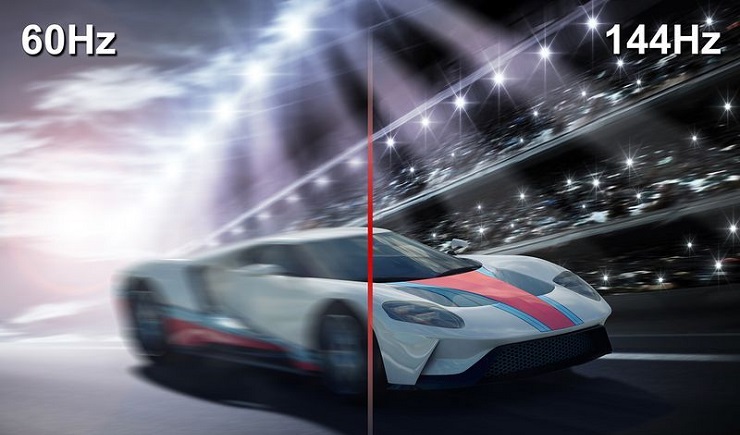

Для начала — что же подразумевается под разгоном матрицы монитора? Подразумевается увеличение частоты обновления монитора со стандартных 60 Гц и на сколько получится — 70-75, бывает и 120, и даже 150 Гц (!). Зачем это нужно? Чтобы повысить плавность картинки. Что означает, что частота обновления монитора — 60 Гц? Это означает, что картинка на экране меняется ровно 60 раз в секунду. При этом видеокарта может выдавать как меньшее количество fps, так и большее. Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам. Если же количество кадров, выдаваемых видеокартой, больше частоты обновления монитора, то получится так, что на экран будет выдаваться сразу два-три кадра, что приведет к артефактам:

Компромиссом является установка вертикальной синхронизации. В чем ее суть? Она жестко привязывает один кадр, подготовленный видеокартой, к одному обновлению картинки на мониторе. И тут, если ваша видеокарта выдает стабильно больше кадров, чем частота обновления монитора, то вы получите идеальную плавную картинку, ну а ваша видеокарта при этом временами не будет загружена на 100% и будет отдыхать. И именно такой режим работы зачастую используется в системе — к примеру, когда вы скроллите в браузере, артефактов вы не видите, и при этом скроллинг плавный.

Поднятие частоты обновления монитора убивает сразу двух зайцев: во-первых, теперь вертикальная синхронизация будет идти на более высокой частоте, а значит плавность еще повысится (думаю, все видели разницу в роликах на YouTube с 30 и 60 кадрами? Вот тут также). Во-вторых, если ваша видеокарта в играх выдавала больше 60 кадров в секунду, то теперь порог появления артефактов отодвигается до новой частоты обновления, при этом информация на экране будет обновляться чаще, что достаточно важно для динамических игр.

Разумеется, возникает вопрос — насколько это безопасно? Гораздо безопаснее разгона железа: если монитор не может работать на заданной частоте, он просто не включится. Если на заданной частоте он заработал — значит, никаких проблем у вас не будет. Перегрев ему, как в случае с разгоном процессора или видеокарты, точно не грозит.

Практика

Теперь, когда немного разобрались с теорией, можно перейти к практике. Первое, что нужно знать — гонится любой монитор и даже матрицы ноутбуков, но тут есть сразу несколько сдерживающих факторов. Первый — это способ подключения: через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц. Ну а через новые HDMI (1.4-2.0), Thunderbolt или DisplayPort ограничений практически нет — можно и 120-165 Гц получить. Аналогично зачастую нет ограничения у матриц ноутбуков, подключенных напрямую к плате. Второй сдерживающий фактор — сама матрица, вернее ее контроллер. Бывает, что даже с быстрым подключением при повышении частоты появляются некоторые артефакты изображения — увы, тут уже ничего не сделаешь, кроме как снижать частоту до последней стабильной.

Сразу предупрежу — проблема программы в том, что у нее нет кнопки Тест, как в случае с Nvidia, поэтому частоты применяются сразу и бесповоротно. Так что если после выставления частоты вы видите черный экран — вам поможет или подключение второго монитора и возврат настроек на дефолтные, или же заход через безопасный режим и проделывание того же самого.

Работать с программой достаточно просто — вы ее запускаете, удаляете все разрешения из стандартных и снимаем все галочки слева (у себя я этого проделывать не буду, ибо уже разогнал матрицу через настройки Nvidia):

Теперь под окном с Detailed resolutions нажимаем на кнопку Add, выставляем Automatic - LCD Reduced и ниже меняем частоту обновления:

Тут принцип тот же — увеличиваем частоту на 3-5 Гц, нажимаем ОК, все сохраняем и перезагружаемся. Теперь заходим в панель AMD (или Intel) и выставляем новую частоту:

Вот, в общем-то, и все — как видите, ничего трудного или опасного нет.

Ну и остается последний вопрос — раз разгоняются почти все матрицы, то почему этого не делают производители с завода? Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц. Во-вторых — зачастую все упирается уже в способ подключения. К примеру, передать 1080р60 можно по любому интерфейсу, хоть DVI, хоть Thunderbolt 3. А вот для 1080р80 уже нужен специальный кабель — DVI и старые HDMI уже не подходят. И чтобы не создавать путаницу, производители опять же ограничились 60 герцами.

Что касается вопроса, разгонять или не разгонять — решать вам и только вам. Если у вас получилось увеличить частоту с 60 до 65 Гц — то смысла в таком разгоне нет, разницу вы не увидите. А вот при разгоне уже до 75 и выше Гц разница становится явно видной, так что игра тут стоит свеч. Также следует учитывать, что после разгона повысится нагрузка на видеокарту при обычной работе — ведь ей теперь придется выдавать больше кадров в секунду, так что если вы разгоняете матрицу на ноутбуке — следует учитывать, что у вас несколько снизится время автономной работы.

@7owkey

1. Сначала ставишь в игре Полноэкранный режим, и только его.

2. Затем скачиваешь RivaTuner.

3. Устанавливаешь вместе с ним RivaTunerStatisticsServer(RTSS).

4. Находишь в основном меню параметр Scanline sync.

5. Устанавливаешь параметр Scanline sync на любое отрицательное значение, к примеру -2.

6. Если на мониторе есть функция Motion Blur Reduction(или аналог), то включаешь её. Она снижает яркость, но дает более плавную картинку засчёт вставки черного кадра. Но есть один глитч с дровами Nvidia, который позволит сделать и яркую картинку и максимальную плавность игры. Для этого придется создать кастомный профиль разрешения. Тебе надо будет зайти в раздел "Изменение разрешения" и там в разделе "Настройка" создать кастомное разрешение с частотой развертки 120 герц(не спрашивай почему, глитч работает только с ним). Далее откроется вкладка "Создание пользовательского разрешения". Там будут разные параметры, но тебя интересует раздел "Синхронизация". В подменю параметра "Стандартное" ты должен выбрать "Вручную". Далее если у тебя FullHD экран идешь в параметр "Всего пикселов" и увидишь там 2 значения: первое лично у меня 2080, у тебя может немного отличаться, второе же ты выставляешь не стандартное, а 1350 пикселей. В итоге у тебя будет чтото типа 2080(или какое-нибудь 2203) слева и 1350 справа. Далее при ВКЛЮЧЕННОЙ Motion Blur reduction (далее MBR) применяешь это кастомное разрешение. В итоге у тебя всё также включен MBR, но картинка не тусклая, а вполне приемлимая по яркости. PROFIT!

Добрый вечер.

Приобрел себе монитор 75hz, до этого сидел на 60hz.

Первое что бросилось в глаза, несомненно - плавность на рабочем столе.

Но уже с запуском серьезных на железо игрушек, заметил что если фпс падает ниже заданной частоте монитора, то бишь ниже 75, то начинается полный дискомфорт, и прямо чувствуется как на экране заметно то падает, то возрастает фпс, играть в такое конечно же совершенно некомфортно. Такими темпами, решил скачать игры которые заранее ограниченны по фпсу. Это геншин импакт и все части дарк соулса. Выяснил что в это играть абсолютно невозможно, плавность появится только если в винде поставить 60 герц, но это уже каша получается, в которую для уже привыкшего глаза к 75 герц невозможно.

В интернете никакой инфы не нашел, а даже если и было, то советовали пользоваться джисинком, благо он у меня есть! Но рано я ликовал, этот джисинк работает через попу, лично у меня. То он в каких то играх в принципе не хочет работать, то где-то нужно включать/выключать v-sync. Эти танцы с бубном сплошной головняк. Даже если и джисинк начинал работать, на экране абсолютно ничего не менялось.

В общем может кто подсказать что это такое? Как с этим играть. Как с этим справляются люди у которых вообще 144hz моник?

p.s Сразу скажу, это не статтеры и не фризы, это первым делом проверил.

Читайте также: